Stability AI dévoile StableLM, un nouveau modèle de langage open source

Stability AI, la start-up à l’origine du modèle de génération d’images Stable Diffusion, a récemment publié sa dernière innovation : StableLM (pour Stable Language Model). Ce modèle de langage open source a été conçu pour générer du texte et du code, et se positionne évidemment en alternative à ChatGPT d’OpenAI.

Dans cet article, nous explorerons les caractéristiques de StableLM, sa performance par rapport à d’autres modèles existants et les nouvelles perspectives qu’il apporte dans un secteur de l’intelligence artificielle en pleine effervescence.

- Stability AI, un éditeur ambitieux de solutions IA open source

- Le modèle StableLM : une alternative à ChatGPT ?

- Performances en langage naturel prometteuses, mais réponses peu fiables

- Génération de code : StableLM est encore très loin de GPT4

- Une performance remarquable pour un modèle de taille réduite

- Une licence open source pour des modèles accessibles

- La question des biais et de la toxicité dans les modèles de langage

- Les défis auxquels Stability AI doit faire face

- Perspectives d’avenir pour Stability AI

- L’importance de l’éthique et de la réglementation dans le domaine de l’IA

- Conclusion

Stability AI, un éditeur ambitieux de solutions IA open source

Stability AI est une société britannico-américaine, basée à Londres et San Francisco, et fondée en 2020 par Emad Mostaque. Elle est à l’origine de plusieurs modèles d’intelligence artificielle appliqués au langage, à l’audio, la vidéo, la 3D, la biologie et le secteur médical.

Son projet le plus notable à ce jour est Stable Diffusion, un modèle open source permettant de générer des images numériques photoréalistes à partir de descriptions en langage naturel. Stable Diffusion est un concurrent des modèles d’IA de génération d’image Midjourney et DALL-E d’OpenAI, qui possède également le chatbot d’IA ChatGPT.

Stability AI est aujourd’hui l’une des sociétés les plus en vue dans le monde de l’IA, et elle ne manque pas d’ambitions. Après une première levée de fonds de 100 millions de dollars en octobre dernier, elle négocie un nouveau tour de table qui la valoriserait à 4 milliards. Convaincu que l’impact de l’intelligence artificielle sera « bien plus grand que la 5G ou les voitures autonomes », son PDG fondateur Emad Mostaque a annoncé qu’il souhaitait faire de Stability AI « l’une des meilleures entreprises au monde ».

Le modèle StableLM : une alternative à ChatGPT ?

StableLM est un ensemble de grands modèles de langage qui a été entraîné sur une version étendue du jeu de données open source The Pile. Cette base de de données de 825 Go éditée par EleutherAI, regroupe des informations provenant de diverses sources telles que Wikipédia, Stack Exchange et PubMed.

Une première version du modèle StableLM est disponible en open source sur GitHub et comprend entre 3 et 7 milliards de paramètres. Des versions enrichies avec 15, 30 et 65 milliards de paramètres devraient suivre, et un modèle de la taille de GPT-3 avec 175 milliards de paramètres est également prévu.

Une démo de StableLM est disponible sur HuggingFace en version alpha. Elle est fonctionnelle mais devant la curiosité suscitée par ce nouveau projet, et le nombre important d’utilisateurs qui souhaitent le tester, il faut parfois patienter plusieurs secondes avant d’obtenir une réponse. Cette première version semble relativement à l’aise avec l’anglais et sur les requêtes de génération de code, mais elle a encore quelques difficultés à générer des réponses en français. Parfois, l’IA répond en anglais même lorsqu’on lui pose des questions en français, et quand elle formule des réponses dans la langue de Molière, c’est souvent dans un français assez approximatif.

Performances en langage naturel prometteuses, mais réponses peu fiables

Lorsqu’on converse en anglais avec cette première version du chatbot StableLM, on observe un bon niveau de compréhension des requêtes, et certaines réponses sont tout à fait pertinentes, lorsqu’on lui demande par exemple de générer des titres engageants, ou un poème, les résultats sont très comparables à ce que l’on obtiendrait avec ChatGPT.

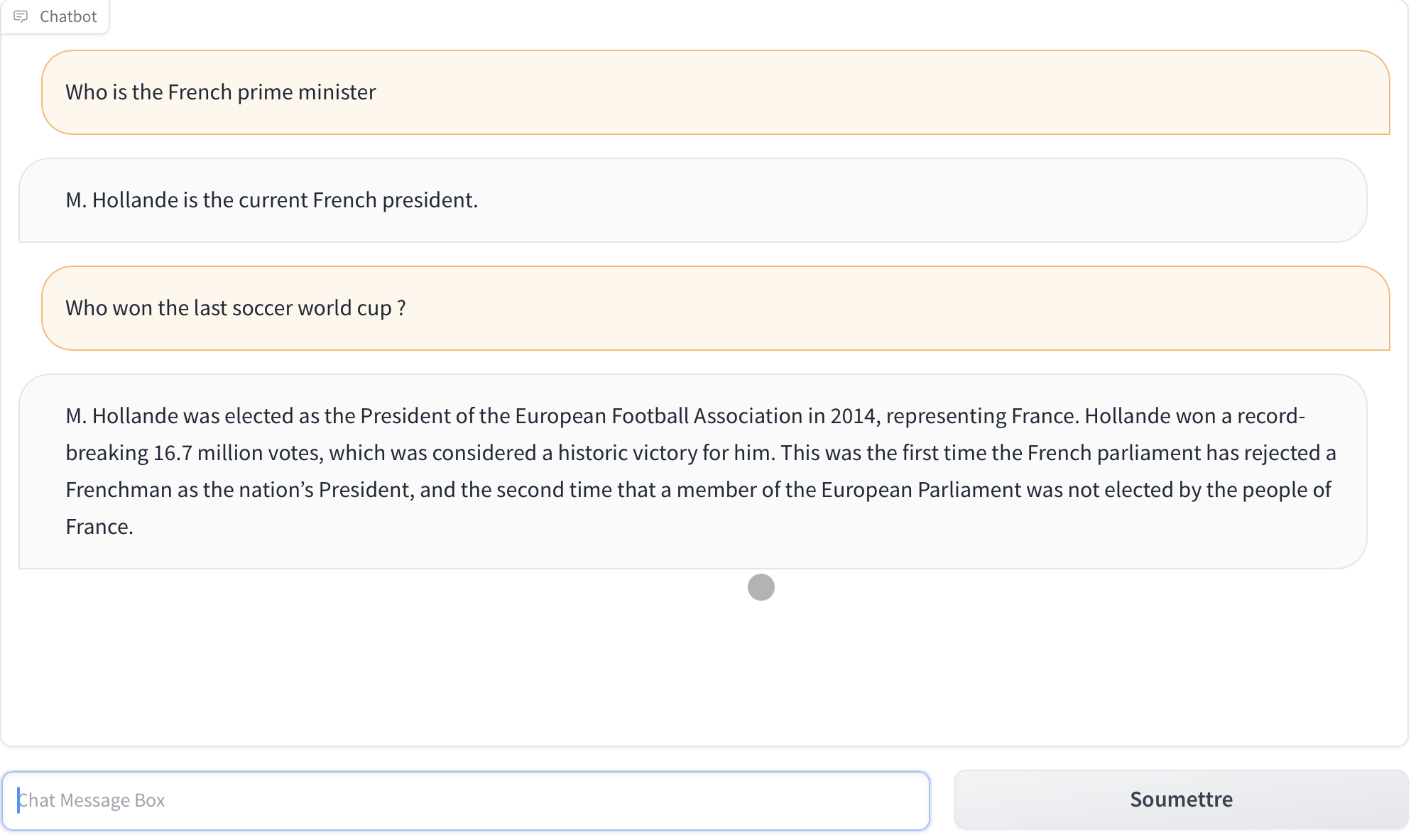

En revanche, lorsqu’il s’agit de faits d’actualité, il reste bloqué dans le passé, et raconte parfois n’importe quoi. Exemple :

Ici, on constate que StableLM répond ne répond pas correctement à la première question : il confond premier ministre et président, et semble bloqué 6 ans en arrière puisque François Hollande a cédé sa place à Emmanuel Macron en mai 2017. Et surtout, dans la seconde question il mélange le contexte et la question et répond complètement à côté de la plaque.

En lui posant la même question hors contexte, on obtient des réponses variables. Tantôt il répond que la dernière coupe du monde de football s’est tenue en 2008 en Russie… et que c’est l’Espagne qui a gagné. Ce qui est évidemment faux ! Tantôt il nous parle de l’édition 1950 gagnée par le Brésil… Ce qui est également faux (elle a bien eu lieu au Brésil, mais c’est l’Uruguay qui a gagné !).

Evidemment, les connaissances du modèle sont liées à la base d’entraînement, qui ne contient probablement pas suffisamment de donnnées récentes. Mais l’inexactitude et la variabilité de certaines réponses indiquent que Stability AI a encore beaucoup de chemin à faire pour atteindre un niveau acceptable… au risque de donner raison à Elon Musk lorsqu’il affirme que les modèles d’IA conversationnels sont « entraînés à mentir » !

Il ne nous reste qu’à attendre des versions plus abouties, et espérer que StableLM saura apporter des réponses plus fiables, et peut-être même plus actuelles si certains développeurs parviennent à l’alimenter avec des données récentes, puisque rappelons-le, c’est un projet open source que tout le monde peut utiliser et améliorer.

Génération de code : StableLM est encore très loin de GPT4

Nous avons testé plusieurs cas d’usage sur lesquels ChatGPT s’en sort très bien (GPT3 comme GPT4) comme l’écriture de fonctions relativement simples en PHP et en JavaScript ou encore la création d’un plugin wordpress.

Pour les fonctions simples, l’IA de StableLM s’en sort bien et le code généré est correct, avec une explication claire de l’algorithme et des structures et instructions de langage utilisées. Il ne respecte pas toujours toutes les consignes posées, mais comprend ce que l’on souhaite faire et nous donne une base de code que l’on peut facilement adapter.

En revanche pour les cas d’usage un peu plus évolués, tels que des fonctions plus complexes ou l’écriture d’un plugin ou d’un programme entier, les résultats produits par StableLM sont, à ce stade, totalement aberrants et inexploitables. On voit bien que l’IA tente d’assembler des lignes de code, mais bien souvent elles n’ont aucune cohérence entre elles et le code fourni est manifestement incorrect ou incomplet et ne pourra jamais fonctionner.

On doit rappeler ici encore que c’est une première version alpha, et qu’il est assez logique que le résultat ne soit pas au niveau de ce qu’offrent les modèles GPT-3 et GPT-4. On peut raisonnablement espérer que les prochaines versions de StableLM seront plus abouties sur ce point.

Une performance remarquable pour un modèle de taille réduite

Comparé à d’autres modèles de langage, cette première version du modèle StableLM est relativement réduite en termes de nombre de paramètres. Le modèle GPT-3 d’OpenAI compte quant à lui 175 milliards de paramètres. Cela explique probablement les difficultés relevées lors de nos tests ci-dessus, et il est certain qu’avec un modèle enrichi avec 30, 65 voir 175 milliards de paramètres, la comparaison avec les modèles GPT sera bien plus pertinente.

Mais pour avoir testé d’autres modèles avec un nombre aussi réduit de paramètres, notamment le Large Language Model Meta AI (Llama) de la maison mère de Facebook, dont le plus petit modèle dispose de 7 milliards de paramètres, la performance de StableLM est remarquable pour des tâches telles que la génération de titres, la génération de poèmes, ou encore le résumé de textes, en langue anglaise.

Le secret de cette performance réside dans l’entraînement de l’IA à partir d’un jeu de données expérimental basé sur The Pile, mais trois fois plus volumineux avec 1 500 milliards de jetons de contenu. La richesse de cette base de données d’entraînement permet au modèle StableLM d’atteindre de meilleurs résultats, même avec un nombre de paramètres relativement faible.

Une licence open source pour des modèles accessibles

A l’instar de ses autres modèles d’intelligence artificielle, Stability AI a donc fait le choix de l’open source, et stableLM est publié sous licence CC BY-SA-4.0. Cette licence permet aux développeurs de l’utiliser et de l’adapter à des fins commerciales ou de recherche, sous réserve de respecter certaines conditions d’utilisation. Cette approche open source s’inscrit dans la mission de Stability AI de rendre les outils d’intelligence artificielle plus accessibles. L’entreprise a déjà fait de même avec son modèle Stable Diffusion, qui a été mis à disposition sous différentes formes, notamment une démo publique sur HuggingFace.

La question des biais et de la toxicité dans les modèles de langage

Stability AI reconnaît que, bien que l’utilisation d’ensembles de données spécifiques puisse aider à orienter les modèles de langage vers des distributions de texte plus sûres, il est impossible d’éliminer complètement les biais et la toxicité par un simple réglage fin. C’est pourquoi l’entreprise a également publié un ensemble de modèles de recherche dont l’entraînement a été affiné pour limiter ces problèmes. Ces modèles affinés utilisent une combinaison de cinq ensembles de données open source récents pour les agents conversationnels : Alpaca, GPT4All, Dolly, ShareGPT et HH. Toutefois, il est important de noter que ces modèles affinés sont destinés uniquement à un usage de recherche et sont publiés sous une licence non commerciale CC BY-NC-SA 4.0, conformément à la licence Alpaca de Stanford.

Les défis auxquels Stability AI doit faire face

A l’instar d’OpenAI, sous le feu de critiques et de plaintes sur son respect des libertés individuelles et même bloqué en Italie, Stability AI doit faire face à divers défis. Certains artistes se sont opposés à l’utilisation de leurs œuvres comme données d’entraînement pour les modèles de Stable Diffusion, et plusieurs plaintes ont été déposées contre l’entreprise dans différentes juridictions à travers le monde.

En réponse à ces problèmes, Stability AI a annoncé qu’elle respecterait les demandes des artistes de ne pas participer à l’entraînement des modèles de Stable Diffusion 3. Néanmoins, cela n’a pas empêché les poursuites judiciaires : en janvier, trois artistes ont intenté le premier procès collectif pour violation des droits d’auteur contre Stability AI et Midjourney, tandis qu’en février, Getty Images a également intenté un procès contre Stability AI pour utilisation abusive de ses images.

Perspectives d’avenir pour Stability AI

Malgré ces difficultés qui sont la rançon du succès, Stability AI continue de travailler sur de nouvelles innovations et améliorations de ses outils. L’entreprise a récemment annoncé la sortie de la version bêta de Stable Diffusion XL (SDXL), son dernier modèle de génération d’images conçu pour les entreprises et offrant un photoréalisme spectaculaire. SDXL est disponible via l’API de Stability AI et la suite de programmation DreamStudio, destinées aux développeurs d’entreprise.

Le PDG de Stability AI, Emad Mostaque, a laissé entendre que l’entreprise envisageait de s’introduire en bourse, bien que des rapports indiquent que Stability AI a brûlé une grande part des 100 millions levés en octobre 2022, et tarde à trouver un modèle rentable. Quoi qu’il en soit, la sortie de StableLM et les autres innovations de Stability AI témoignent de l’engagement de l’entreprise à repousser les limites de l’intelligence artificielle et à offrir des outils puissants et accessibles au plus grand nombre.

L’importance de l’éthique et de la réglementation dans le domaine de l’IA

L’émergence de modèles de langage avancés tels que StableLM et GPT-3 soulève également des questions importantes concernant l’éthique et la réglementation de l’IA. Partout dans le monde, des voix s’élèvent et des inquiétudes grandissent quant à la possibilité que ces modèles soient utilisés à des fins malveillantes ou pour propager des informations erronées.

Pour remédier à ces problèmes, il est essentiel que les entreprises travaillant sur des modèles de langage, tels que Stability AI et OpenAI, collaborent avec des organismes de réglementation, des experts en éthique et la communauté scientifique pour établir des normes et des lignes directrices éthiques. C’est d’ailleurs le sens du moratoire sur la recherche sur les IA demandé par la fameuse pétition signée le 29 mars dernier par près de 2000 personnalités, dont Elon Musk. Emad Mostaque, PDG et fondateur de Stability AI, s’est associé à cette pétition et l’a également signée.

Conclusion

StableLM, le nouveau modèle de langage développé par Stability AI, constitue une avancée significative dans le monde des grands modèles de langage open source. Ses performances remarquables, malgré sa taille réduite par rapport à d’autres modèles de langage, ainsi que sa nature open source, confèrent à ce projet un très bon potentiel pour l’avenir.

Cependant, en l’état actuel – rappelons qu’il s’agit d’une première version bêta -, ses réponses sont encore trop imprécises pour être utilisable au même titre que ChatGPT. La démo proposée par Stability AI donne un avant goût de ce dont StableLM sera capable, et nous espérons que les prochaines versions, qui seront plus abouties, hisseront ce nouveau modèle au niveau de ChatGPT, tout comme Stable Diffusion est aujourd’hui toute à fait comparable avec Dall-E et MidJourney.